Friday, 18 September

2020/9/18(金)

一般発表 10:30-11:50 ARシステム

座長:神原 誠之(奈良先端大学)

- 3B2-1

-

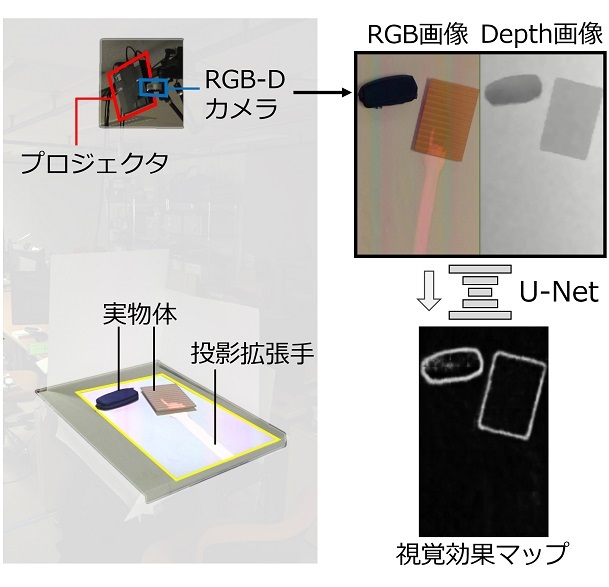

- 投影型拡張手インタラクションに対する深層学習を用いた触覚フィードバック推定

〇佐藤 優志(大阪大学)、平木 剛史(大阪大学)、松倉 悠(大阪大学)、岩井 大輔(大阪大学)、佐藤 宏介(大阪大学) - プロジェクタからユーザの手の代替となる拡張手を投影する拡張現実インタフェースにおいて、投影拡張手が実物体に触れた際ユーザはその触感を得られない。この問題に対し拡張手への視覚効果から疑似触覚を提示する手法があるが、物体輪郭や質感に関する事前付与が必要となる。そこで、シーンのRGB-D画像から深層学習により動的に適切な視覚効果や触覚フィードバックを推定し付与するシステムを提案する。

- 3B2-2

-

- 視覚特性に基づく光学透過型HMDでの透明物体表現法

〇木村 勇斗(立命館大学)、木村 朝子(立命館大学)、柴田 史久(立命館大学) - 実物の透明物体が持つ視覚効果を,AR/MRで表現する透明物体に再現する.人間が実物の透明物体を観察する際,複数の光学距離が異なる像が混じり合うことにより特有の視覚効果が発生する.しかしこれまでの手法で表現した透明物体をAR/MR用HMDに提示した場合,いくつかの理由によりこれらの視覚効果が十分に再現されない.本発表では,光学透過型HMDでのAR/MR環境下で,観察者の視線情報を用いて疑似的に視覚効果を再現する手法を提案する.

- 3B2-3

-

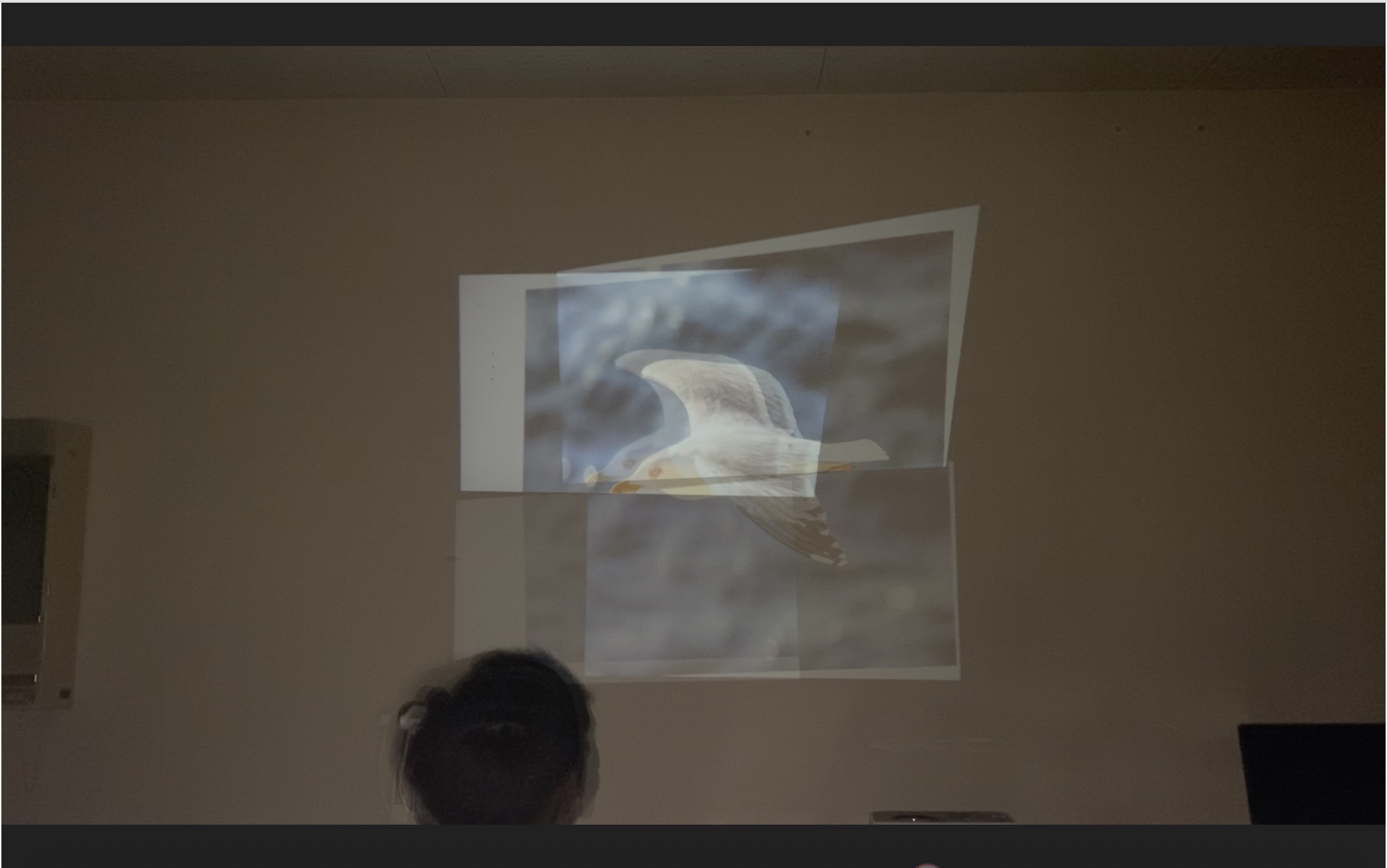

- 頭部搭載型プロジェクタを用いたウェアラブル拡張現実感システム

〇飯盛 正慶(埼玉大学)、小室 孝(埼玉大学) - 本論文では,場所の制約なく使用でき,実環境に固定された映像が提示できるウェアラブル拡張現実感システムを提案する.

提案するシステムでは,プロジェクタを頭部に搭載し、頭部の位置姿勢をリアルタイムに推定することにより,表示する仮想空間上の物体が実空間に固定されているような映像を提示する.さらに,プロジェクタの位置を視点の位置に近づけることで,投影面の形状に依存しない映像投影を可能にする.

- 3B2-4

-

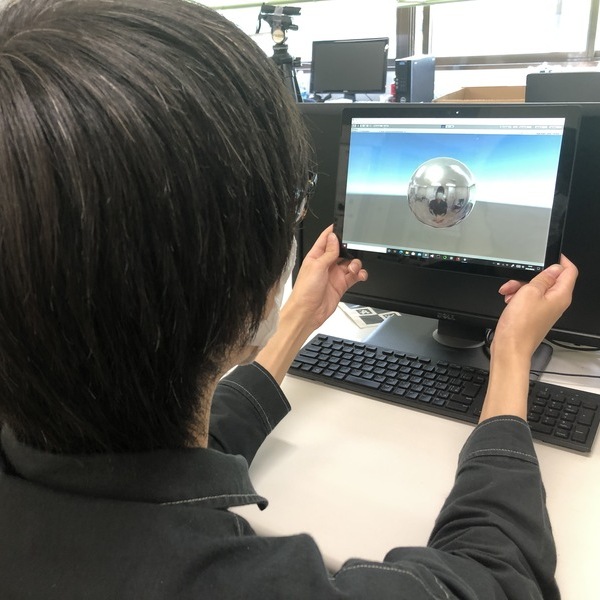

- モバイルARにおける前面カメラ画像の外挿を用いた映り込みの再現

〇小田嶋 駿(埼玉大学)、小室 孝(埼玉大学) - 本研究では,モバイル端末を用いたARにおいて、端末の前面カメラで撮影した画像のみを用いて,仮想物体への実シーンの映り込みを再現する手法を提案する.モバイル端末の前面カメラで端末手前のシーンを画像として取得し,それを用いて映り込みの一部分を再現する.また,その周囲部分を補間することで,映り込みに十分な範囲のシーンを推定する.

- 3B2-5

-

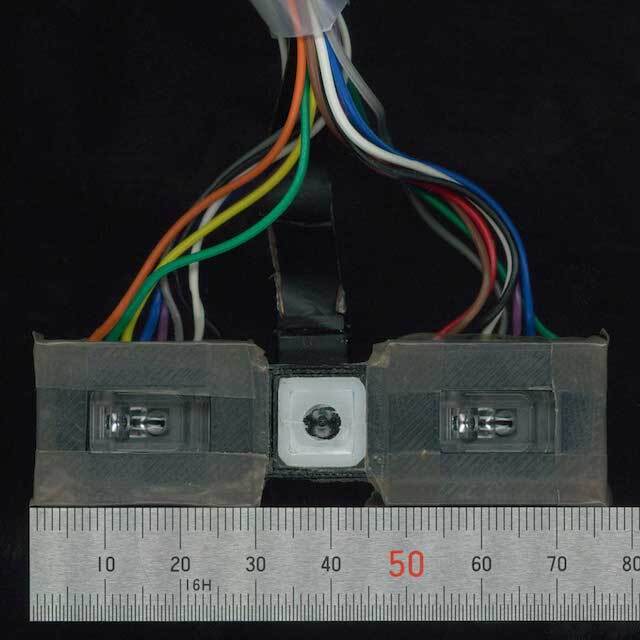

- 指先顕微鏡における指先の移動量に基づくリアルタイムスティッチング

〇重見 和秀(東京大学)、大伏 仙泰(東京大学)、檜山 敦(東京大学)、稲見 昌彦(東京大学) - 本稿では既発表の指先に装着可能な顕微鏡デバイスを用いた,指先の移動に基づく広視野像の構築手法を報告する.広視野像のリアルタイムスティッチングは指先の移動に基づく顕微鏡観察を容易にする一方,顕微鏡画像のみで広視野像の構築を試みる場合,許容される移動量は画角の制約を受け,画像処理の実行時間も課題となる.提案手法では移動量センサの併用により,画角に非依存かつリアルタイムなスティッチングが実現された.

- 3B2-6

-

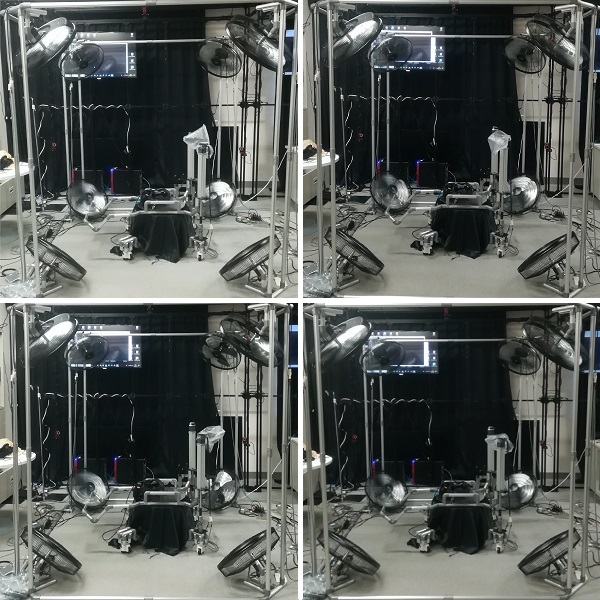

- リアルからバーチャルに干渉可能な全方位型MR風力呈示システム

〇劉 ジンイ(広島市立大学)、脇田 航(広島市立大学) - 本研究ではリアルからバーチャルに干渉可能な全方位型MR風力呈示システムを提案する.具体的には,リアル側のユーザがVIVEコントローラーで仰ぐと,仰ぐ速度と方向に応じた風が現実世界とバーチャル世界共に発生する.このシステムを利用することによって,例えばフライトコンテンツにおいて,フライト中のユーザの操作を邪魔したり,支援したりする等,観覧者も一緒になって同じVRコンテンツを楽しむことが期待できる.

- 3B2-7

-

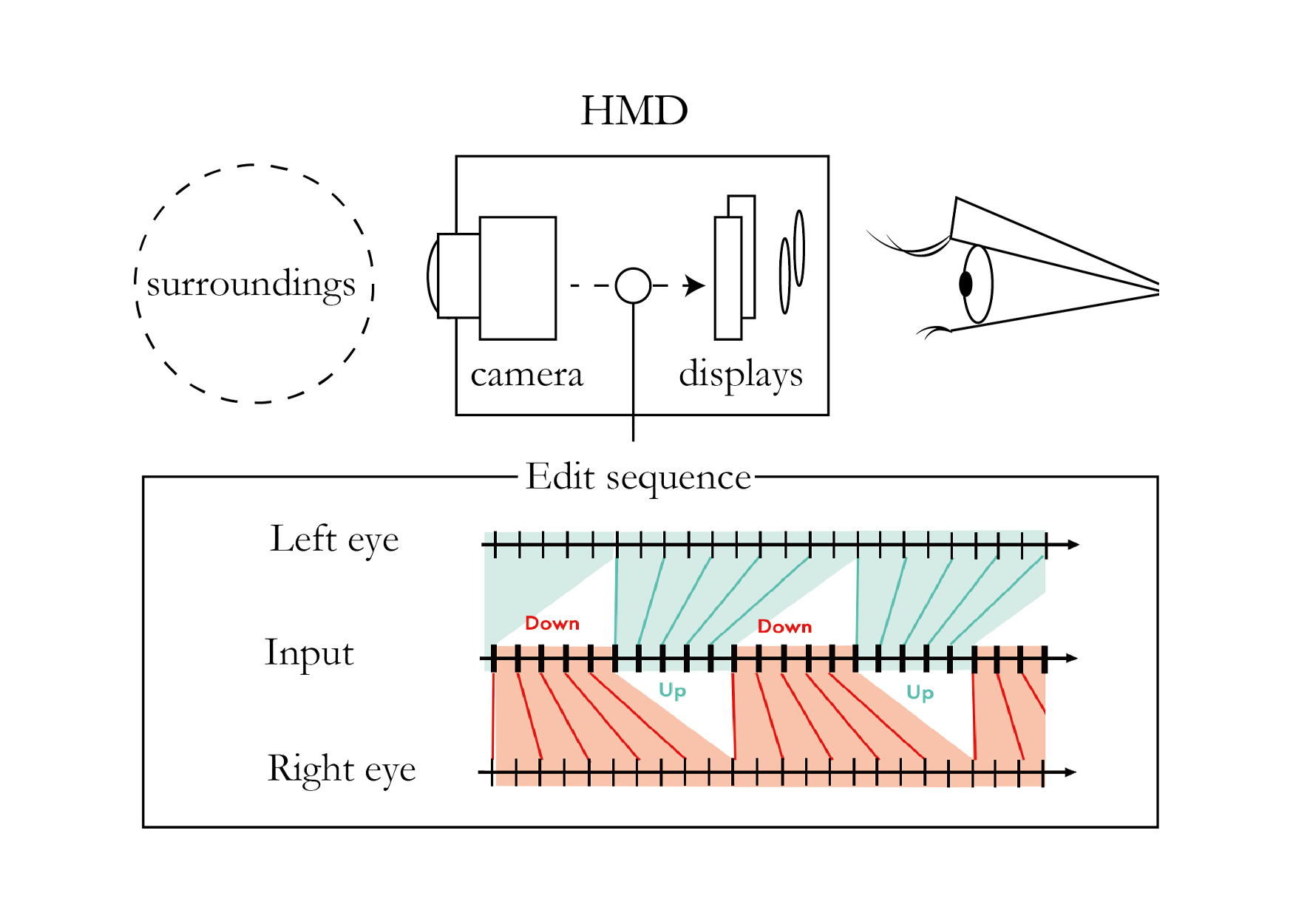

- リアルタイムとスローモーションを共存させるインタフェース

〇村本 剛毅(東京大学)、齊藤 寛人(東京大学)、脇坂 崇平(東京大学)、笠原 俊一(東京大学、ソニーコンピュータサイエンス研究所)、稲見 昌彦(東京大学) - 実時間の中にスローモーションを体験するインタフェースを提案する.具体的には,入力映像を2つの拍に分割し,それぞれを1/2倍速にしたものを両眼に分けて提示し,それら2つを異なるタイミングでリアルタイムの映像に戻すことで,連続的なスローモーションを維持しつつ,実時間との乖離が広がらない映像提示環境を構築した.実験により,提案手法によって被験者が連続性のあるスローモーション体験を得たことが示唆された.